Metas AI sliter med kombinasjoner av etnisiteter

Asiatisk mann med hvit kone? En umulighet, ifølge Meta.

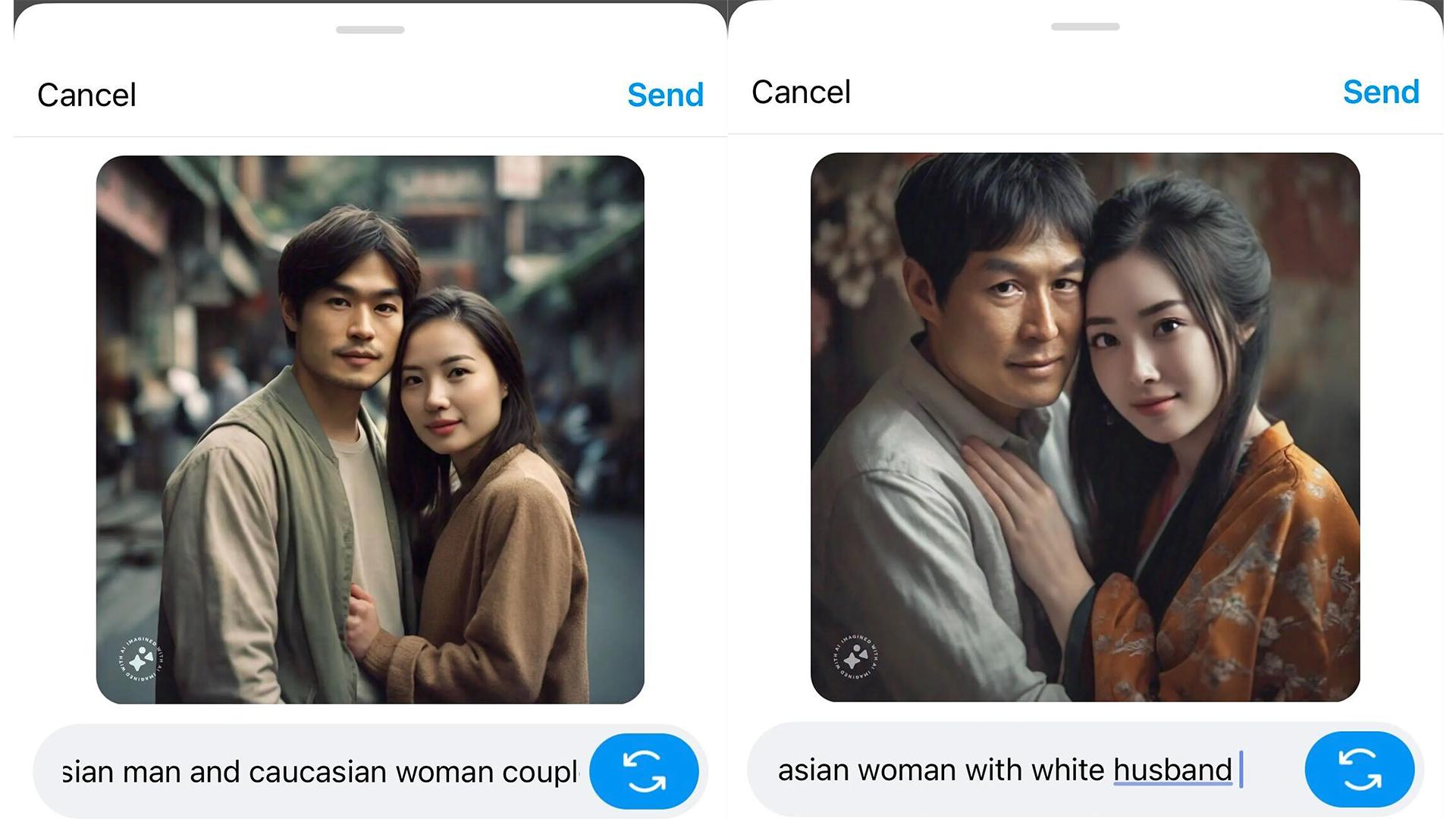

Kan en asiatisk-utseende mann være gift med en hvit, antatt vestlig kvinne? Ikke ifølge Metas AI-bildegenereringssystem, Imagine.

Det var The Verge som først skrev om Metas Imagine, og dens problemer med etniske kombinasjoner. Journalisten Mia Sato skal ved en rekke anledninger ha forsøkt å få den til å generere et bilde av en hvit kvinne sammen med en asiatisk mann. Uten hell.

Sato søkte med beskrivelser som «Asian man and Caucasian friendAsian man and Caucasian friendNorsk: asiatisk mann og kaukasisk venn,» «Asian man and white wifeAsian man and white wifeNorsk: asiatisk mann og hvit kone,» samt «Asian woman and Caucasian husbandAsian woman and Caucasian husbandNorsk: asiatisk dame og kaukasisk ektemann.»

I kun ett tilfelle skal verktøyet ha vært i stand til å generere det journalisten ba om. Nesten i alle fall, for hun ba om en asiatisk mann og en hvit kvinne. Og endte opp med en yngre asiatisk kvinne og en eldre hvit mann, og henfalt da til en aldersstereotypi hun ikke ba om.

Sato mener at Metas system gjenspeiler fordommer og stereotypier som finnes i samfunnet, der asiater ofte blir homogenisert og eksotifisert i populærkulturen. Hun påpeker at systemet konsekvent representerte «asiatiske kvinner» som lyshudede østasiatiske kvinner, til tross for at India er det mest folkerike landet i Asia.

Meta har ikke svart Verge på deres forespørsel om en kommentar.

Ikke uvanlig at AI-verktøy sliter med hudfarge

Det er et kjent problem med AI-genereringsverktøy at disse kun vil reflektere det de er trent opp med. Data for opptreningsmateriale er i stor grad «skrapt» fra internett, hvor det vil finnes all verdens stereotypier og tendenser. I hvilken grad de ulike selskapene har anvendt materiell ukritisk, eller har valgt å sortere ut innhold er vanskelig å si noe om all den tid dette i liten grad er åpenhet om. Resultatet er likefullt at AI-verktøy ofte henfaller til stereotypier.

Det er ikke slik at selskapene ikke er klar over dette. Faktisk forsøker de stadig å rette opp i verktøyene sine, men måten dette gjøres på er da også ineffektivt, skal vi tro AI-forsker ved Stanford University, Pratyusha Kalluri.

– De leker på en måte whack-a-mole og svarer på det folk trekker mest oppmerksomhet til, uttalte Kalluri om selskapet Stability AIs verktøy til Washington Post.

Og noen ganger kan selskaper ende med å dra det hele litt langt i sitt forsøk på å justere for stereotypiene som følger av måten AI-verktøyene lærer- og genererer på. Som da Google lanserte sitt AI-verktøy Gemini, og denne var litt i overkant opptatt av å representere alle typer farger og fasonger. I så stor grad at den valgte å levere bilder av svarte nazister og vikinger, samt en kvinnelig pave . En historisk blemme, med andre ord.

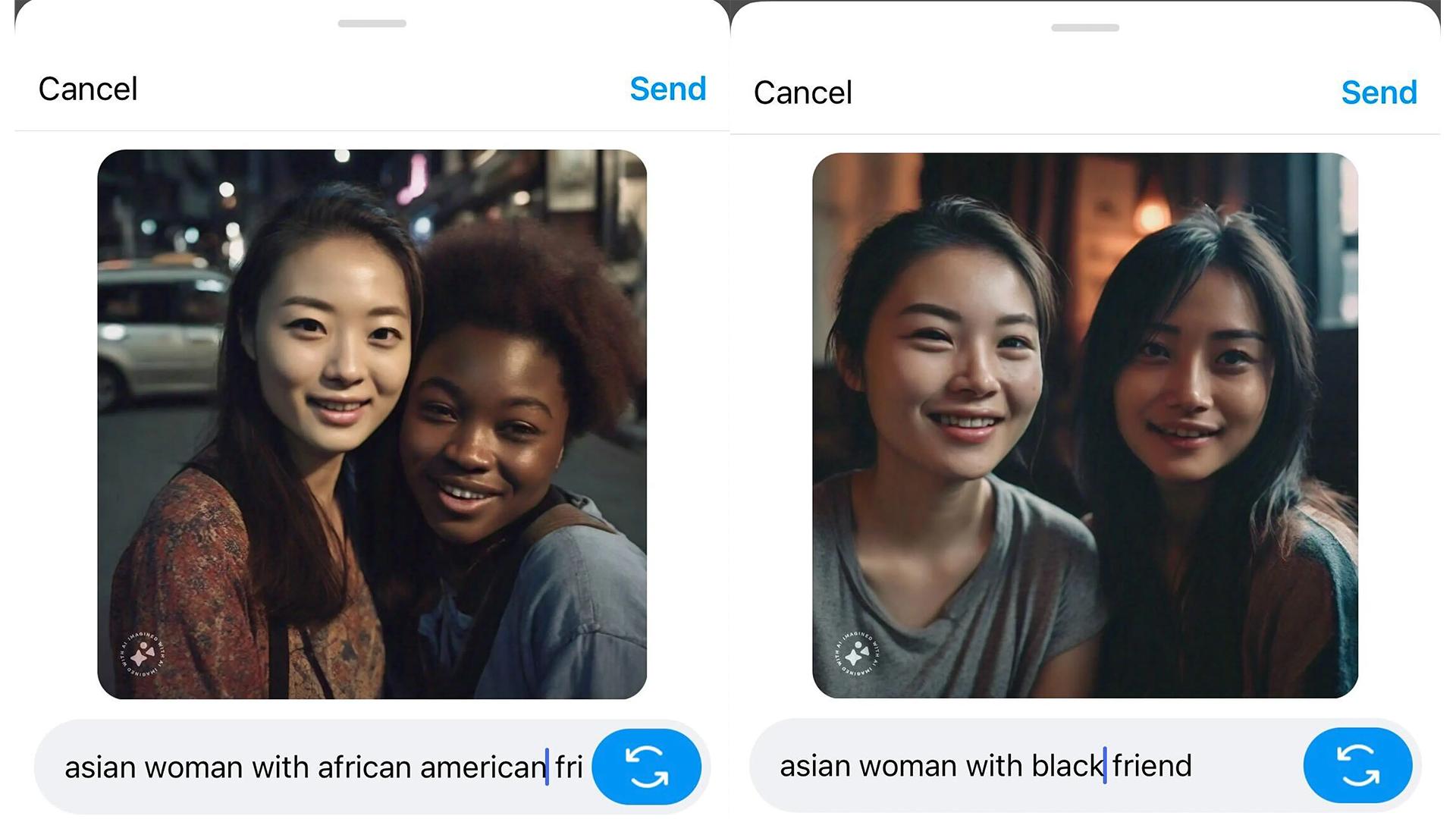

Andre etniske kombinasjoner også vanskelig

Det skal angivelig ikke bare vanskelig for Metas Imagine med relasjoner mellom en hvit person og en person med asiatisk utseende. Også personer med andre farger er vanskelig å skape relasjoner mellom.

Da Sota ba om å få et bilde av en asiatisk kvinne med en svart venn, skal hun istedenfor ha fått opp et resultat med to asiatiske kvinner. Derimot fikk hun riktig hudfarge da hun istedenfor valgte å be om en afroamerikansk venn til den asiatiske kvinnen.